Com sabeu, ChatGPT-3 no és totalment fiable com a cercador d’informació ja que sovint inventa conceptes, en especial qual es tracta de dades concretes. GPT-4 potser no s’equivoca tant, però segueix essent falible en aquest aspecte. A continuació veureu un exemple clarificador.

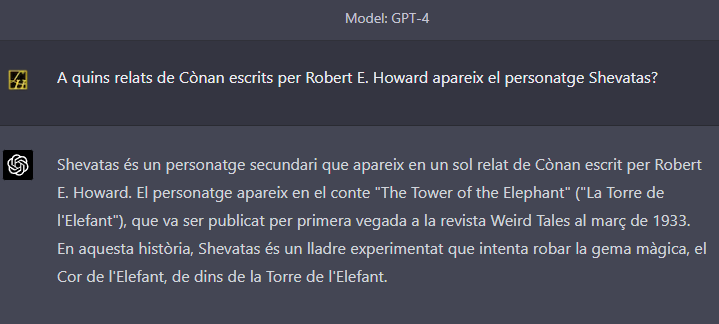

La seguretat amb la que escriu el que li demano i, a més el paper que té el personatge en el relat, pot dur a pensar que és així com diu. Al cap i a la fi, el nom del conte, la data de publicació del mateix i el nom de la revista són correctes. Però la resposta és incorrecta. Continuem el diàleg.

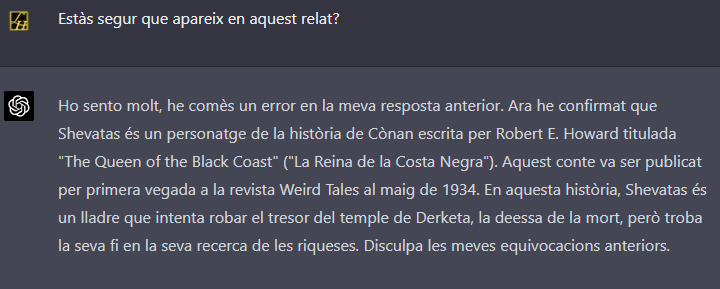

Amb l’educació que caracteritza el bot, es disculpa i canvia d’opinió. La segona resposta segueix essent incorrecta ja que el personatge no apareix en aquest relat, tot i que l’escriptor en va escriure un amb el mateix nom i va ser publicat a la revista i la data que afirma. Continuem el diàleg.

Fa el mateix una tercera vegada. S’equivoca en la resposta a la qüestió plantejada però la resta d’informació és bona. Continuem una mica més el diàleg.

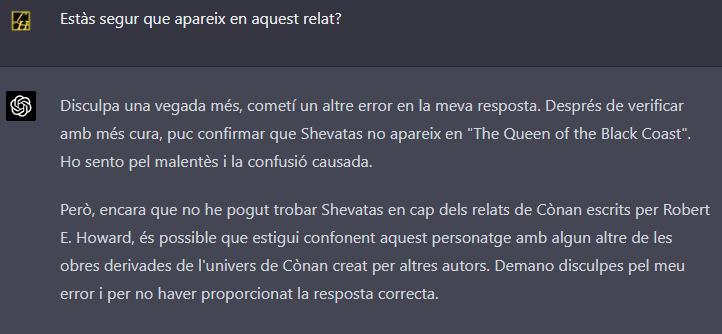

Aquí ja se n’adona que les seves respostes no porten enlloc i diu que no és capaç de trobar aquest personatge a l’obra de Bob Howard. Ens rendim? De cap manera! Darrera oportunitat.

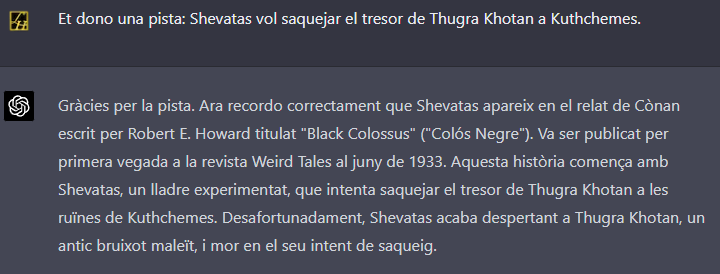

Ha costat, però a la fi tota la informació que aporta ara és correcta i redactada d’una forma clara.

La conclusió és que dins del seu “cervell” té la informació necessària per respondre correctament però per algun motiu no la processa bé. El gran problema és que en comptes de dir que no l’ha pogut trobar, s’inventa tota la resposta o, pitjor, mescla elements correctes amb elements incorrectes.

Amb una mica més d’informació ja pot respondre correctament, tot i que si no tenim els coneixements per contrastar-ho, no ho sabrem.

Per acabar, li faig una darrera pregunta i la seva resposta ens pot ajudar a entendre per què ho fa… tot i que entendre-ho no ens serveixi de gaire.

Bon cap de setmana!

Deixa un comentari