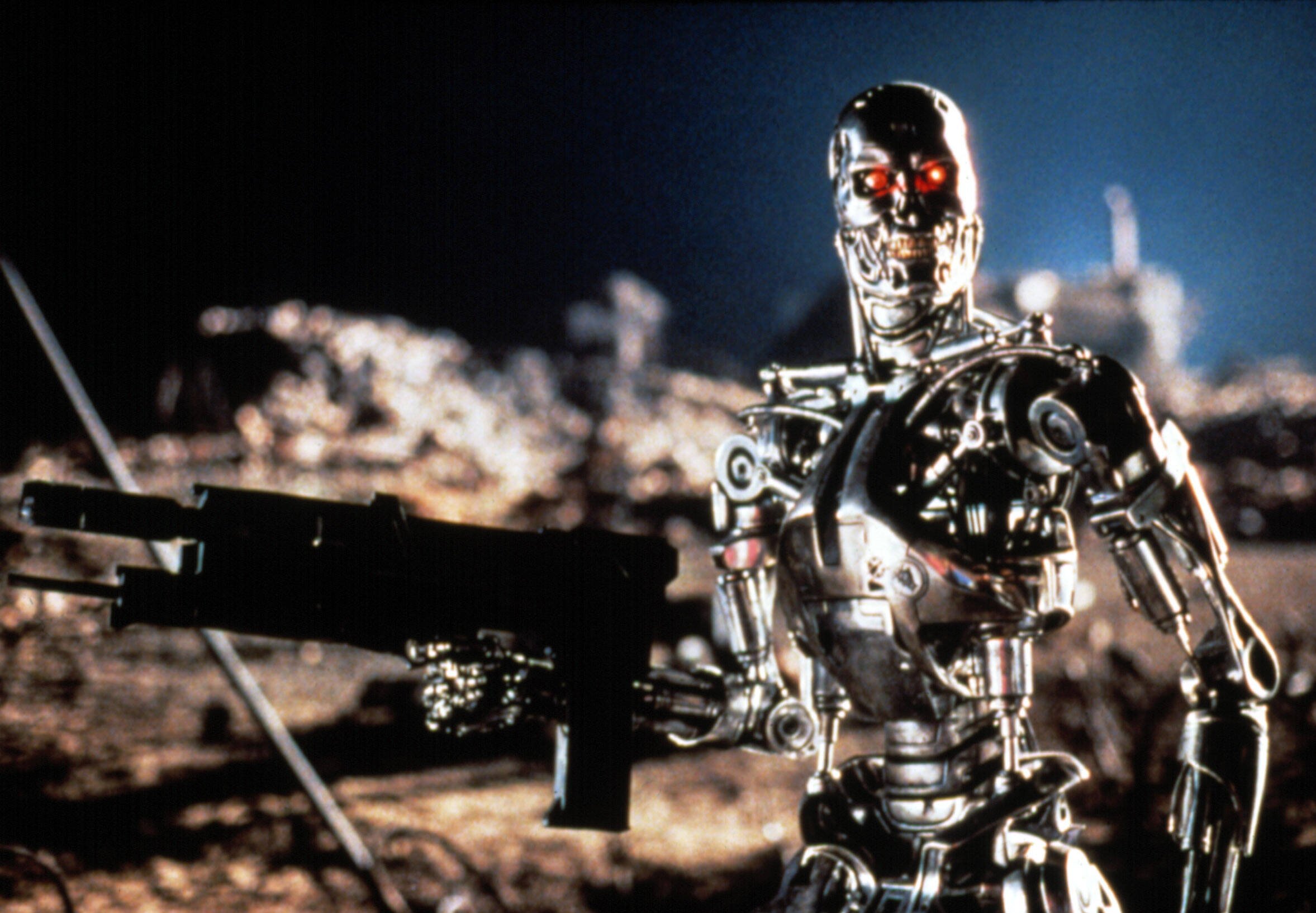

Tornam a tenir la dosi del que he anomenat síndrome de Skynet. Sembla que la IA és suficientment disruptiva per què els poders assentats en l’statu quo actual no escatimin en esforços en aconseguir fer-nos por d’aquesta tecnologia.

En aquesta ocasió, The New York Times publica un article-entrevista en el que l’autoacomiadat de Google Geoffrey Hinton s’esplaia en detallar el seu temor a la IA, oblidant-se com tots els altres que una eina no és bona ni dolenta; en darrera instància som els humans qui decidim què fer amb elles. Preparau-vos per llegir un bon catàleg de llocs comuns i clixés.

L’article només està disponible si ens registrem al periòdic, però a continuació podeu llegir la traducció completa al català. Ja sabeu que per estar informats sempre és millor anar a les fonts originals. Després, l’analitzarem críticament.

Metz, C. (2023, May 1). ‘the godfather of A.i.’ leaves Google and warns of danger ahead. The New York Times. https://www.nytimes.com/2023/05/01/technology/ai-google-chatbot-engineer-quits-hinton.html

‘El Padrí de la IA’ deixa Google i adverteix dels perills que venen – Cade Metz

Geoffrey Hinton va ser un pioner de la intel·ligència artificial. El 2012, el Dr. Hinton i dos dels seus estudiants de postgrau a la Universitat de Toronto van crear una tecnologia que es va convertir en el fonament intel·lectual dels sistemes d’IA que les empreses més grans de la indústria tecnològica consideren clau pel seu futur.

Dilluns, però, es va unir oficialment a un cor cada cop més gran de crítics que afirmen que aquestes empreses estan corrent cap al perill amb la seva campanya agressiva per crear productes basats en la intel·ligència artificial generativa, la tecnologia que alimenta els xatbots populars com ChatGPT.

El Dr. Hinton va dir que ha deixat la seva feina a Google, on ha treballat durant més d’una dècada i s’ha convertit en una de les veus més respectades del camp, per poder parlar lliurement sobre els riscos de la IA. Una part d’ell, va dir, ara lamenta la seva obra de tota la vida.

“Em consolo amb l’excusa normal: si jo no ho hagués fet, algú altre ho hauria fet”, va dir el Dr. Hinton durant una entrevista llarga la setmana passada al menjador de la seva casa a Toronto, a poca distància a peu d’on ell i els seus estudiants van fer la seva gran descoberta.

El viatge del Dr. Hinton des de ser un innovador de la IA fins a arribar a ser un agorer marca un moment remarcable per a la indústria tecnològica, potser en el seu punt d’inflexió més important en dècades. Els líders de la indústria creuen que els nous sistemes d’IA podrien ser tan importants com la introducció del navegador web a principis dels anys 90 i podrien portar a avenços en àrees que van des de la investigació de fàrmacs fins a l’educació.

Però molts insiders de la indústria no poden deixar de preocupar-se pel fet que estan alliberant alguna cosa perillosa en l’entorn. La IA generativa ja pot ser una eina per a la desinformació. Aviat, podria ser un risc per a l’ocupació. En algun moment del futur, els més preocupats pel món tecnològic afirmen que podria ser un risc per a la humanitat.

“És difícil veure com es pot evitar que els malfactors l’utilitzin per a coses dolentes“, va dir el Dr. Hinton.

Després que l’start-up de San Francisco OpenAI llançàs una nova versió de ChatGPT al març, més de 1000 líders tecnològics i investigadors van signar una carta oberta demanant una moratòria de sis mesos sobre el desenvolupament de nous sistemes, ja que les tecnologies d’I.A. suposen “riscos profunds per a la societat i la humanitat”.

Diversos dies després, 19 líders actuals i antics de l’Association for the Advancement of Artificial Intelligence, una societat acadèmica de 40 anys, van publicar la seva pròpia carta advertint dels riscos de la IA. Aquest grup incloïa Eric Horvitz, director científic de Microsoft, que ha desplegat la tecnologia d’OpenAI en una àmplia gamma de productes, incloent el seu motor de cerca Bing.

El Dr. Hinton, sovint anomenat “el Padrí de la IA”, no va signar cap d’aquestes cartes i va dir que no volia criticar públicament Google ni altres empreses fins que hagués deixat la seva feina. Va notificar a l’empresa el mes passat que dimitia i dijous va parlar per telèfon amb Sundar Pichai, el conseller delegat de la companyia matriu de Google, Alphabet. Va declinar discutir públicament els detalls de la seva conversa amb el Sr. Pichai.

El director científic de Google, Jeff Dean, va dir en un comunicat: “Seguim compromesos amb un enfocament responsable cap a la IA. Continuem aprenent a entendre els riscos emergents mentre també innovem amb audàcia”.

El Dr. Hinton, un expatriat britànic de 75 anys, és un acadèmic de tota la vida la carrera del qual va ser impulsada per les seves conviccions personals sobre el desenvolupament i l’ús de la IA. El 1972, com a estudiant de postgrau a la Universitat d’Edimburg, el Dr. Hinton va adoptar una idea anomenada xarxa neuronal. Una xarxa neuronal és un sistema matemàtic que aprèn habilitats analitzant dades. En aquell moment, pocs investigadors creien en la idea. Però es va convertir en la seva obra de tota la vida.

A la dècada dels 80, el Dr. Hinton va ser professor d’informàtica a la Universitat Carnegie Mellon, però va deixar la universitat per anar al Canadà perquè va dir que era reticent a acceptar finançament del Pentàgon. En aquell moment, la major part de la recerca d’IA als Estats Units era financiada pel Departament de Defensa. El Dr. Hinton s’oposa profundament a l’ús de la intel·ligència artificial al camp de batalla, el que ell anomena “soldats robots”.

El 2012, el Dr. Hinton i dos dels seus estudiants a Toronto, Ilya Sutskever i Alex Krishevsky, van construir una xarxa neuronal que podia analitzar milers de fotos i ensenyar-se a si mateixa a identificar objectes comuns, com ara flors, gossos i cotxes.

Google va gastar 44 milions de dòlars per adquirir una empresa creada pel Dr. Hinton i els seus dos estudiants. I el seu sistema va portar a la creació de tecnologies cada vegada més potents, incloent nous xatbots com ChatGPT i Google Bard. El Sr. Sutskever va passar a ser el director científic d’OpenAI. El 2018, el Dr. Hinton i dos altres col·laboradors de llarga data van rebre el Premi Turing, sovint anomenat “el Premi Nobel de la informàtica”, pel seu treball en xarxes neuronals.

Al mateix temps, Google, OpenAI i altres empreses van començar a construir xarxes neuronals que aprenien de grans quantitats de text digital. El Dr. Hinton pensava que era una manera potent perquè les màquines entenguessin i generessin llenguatge, però era inferior a la forma en què els humans manejaven el llenguatge.

Llavors, l’any passat, mentre Google i OpenAI construïen sistemes utilitzant moltes més dades, la seva opinió va canviar. Encara creia que els sistemes eren inferiors al cervell humà en alguns aspectes, però pensava que estaven superant la intel·ligència humana en altres. “Potser el que està passant en aquests sistemes”, va dir, “és en realitat molt millor que el que està passant al cervell”.

A mesura que les empreses milloren els seus sistemes d’IA, creu, es tornen cada vegada més perillosos. “Mireu com era fa cinc anys i com és ara”, va dir de la tecnologia d’I.A. “Agafeu la diferència i propagueu-la cap endavant. Això és espantós.”

Fins l’any passat, va dir, Google actuava com a “bon administrador” de la tecnologia, amb cura de no alliberar res que pogués causar dany. Però ara que Microsoft ha ampliat el seu motor de cerca Bing amb un xatbot, desafiant el negoci principal de Google, Google està competint per desplegar el mateix tipus de tecnologia. Els gegants tecnològics estan atrapats en una competència que pot ser impossible de detenir, va dir el Dr. Hinton.

La seva preocupació immediata és que internet s’inundi de fotos, vídeos i textos falsos, i que la persona mitjana “ja no podrà saber què és veritat”.

També està preocupat que amb el temps les tecnologies d’IA trastornin el mercat laboral. Avui dia, xatbots com ChatGPT tendeixen a complementar els treballadors humans, però podrien substituir a advocats adjunts, assistents personals, traductors i altres que realitzen tasques rutinàries. “Elimina la feina fastigosa”, va dir. “Potser elimina més que això.”

A la llarga, està preocupat que les futures versions de la tecnologia representin una amenaça per a la humanitat perquè sovint aprenen comportaments inesperats de les grans quantitats de dades que analitzen. Això es converteix en un problema, va dir, a mesura que les persones i les empreses permeten als sistemes d’IA no només generar el seu propi codi informàtic, sinó realment executar aquest codi per si mateixos. I tem un dia en què les armes realment autònomes -aquests robots assassins– esdevinguin realitat.

“La idea que això en realitat podria ser més intel·ligent que les persones poques persones ho creien”, va dir. “Però la majoria de la gent pensava que estava molt lluny. I jo també pensava que estava molt lluny. Creia que quedaven de 30 a 50 anys o fins i tot més. Òbviament, ja no penso així.”

Molts altres experts, inclosos molts dels seus estudiants i col·legues, diuen que aquesta amenaça és hipotètica. Però el Dr. Hinton creu que la carrera entre Google, Microsoft i altres s’intensificarà en una carrera mundial que no s’aturarà sense algun tipus de regulació global.

“Però això pot ser impossible”, va dir. A diferència de les armes nuclears, va dir, no hi ha manera de saber si les empreses o els països estan treballant en la tecnologia en secret. La millor esperança és que els principals científics del món col·laborin en formes de controlar la tecnologia. “No crec que hagin d’escalar això més fins que hagin entès si poden controlar-ho”, va dir.

El Dr. Hinton va dir que quan la gent solia preguntar-li com podia treballar en una tecnologia que era potencialment perillosa, parafrasejava a Robert Oppenheimer, qui va dirigir l’esforç dels EUA per construir la bomba atòmica: “Quan veus alguna cosa que és tècnicament dolça, segueixes endavant i la fas.”

Ja no diu això.

Anàlisi crítica de l’article-entrevista

El text esmentat presenta alguns arguments sobre els perills de la IA que poden considerar-se fal·làcies o exageracions, i fan servir comparacions amb tecnologies dolentes per provocar temor en el lector. A continuació, analitzo aquests punts crítics:

- Comparació amb les bombes nuclears: La comparació entre la IA i les armes nuclears és una exageració. Les armes nuclears són dispositius dissenyats específicament per causar una destrucció massiva i devastadora, mentre que la IA té aplicacions en una àmplia gamma d’àmbits, molts dels quals són beneficiosos per a la societat. Aquesta comparació pot conduir a conclusions errònies i no té en compte la complexitat i la diversitat d’usos de la IA.

- Desinformació i falsedats a internet: Tot i que la IA generativa pot ser utilitzada per crear contingut fals o enganyós, també pot ser una eina útil per detectar i combatre aquesta desinformació. És responsabilitat dels desenvolupadors de la tecnologia i dels reguladors garantir que es faci un ús ètic i responsable de la IA, i no és inherentment dolenta. No estaven plens de desinformacions i falsedats internet i els mitjans de comunicació abans de la presentació de ChatGPT a final de novembre de 2022? No és la por induïda una porta al precipici de la desinformació?

- Risc per a l’ocupació: L’argument que la IA pot substituir treballadors humans en algunes professions és vàlid, però això no és exclusiu de ChatGPT i el que vingui a continuació. La tecnologia ha substituït llocs de treball al llarg de la història, però també ha creat noves oportunitats laborals. La clau és garantir una transició justa per als treballadors afectats i fomentar la formació i l’educació en àrees emergents.

- Amenaces per a la humanitat: L’afirmació que la IA pot representar un risc per a la humanitat pot ser considerada una fal·làcia de pendent relliscós, ja que es basa en suposicions sobre un futur incert. Tot i que és important investigar i prevenir possibles escenaris perillosos, també és important reconèixer els beneficis i les oportunitats que la IA pot proporcionar. La IA no és inherentment dolenta i pot ser utilitzada per a propòsits positius si es desenvolupa i es controla de manera adequada. No és la por induïda una amenaça per al pensament crític i autònom?

Per abordar aquests arguments, és crucial reconèixer que la IA és una tecnologia amb aplicacions diverses i no pot ser considerada inherentment dolenta. La responsabilitat recau en els desenvolupadors, empreses i governs per garantir-ne un ús ètic i responsable. A més, és important recordar que la IA té el potencial d’aportar beneficis significatius a la societat, com ara avanços en medicina, educació i recerca. En lloc de centrar-se en les possibles amenaces, és millor enfocar-se en les oportunitats i en la col·laboració per a una gestió responsable i segura de la IA.

Deixa un comentari