La reciente decisión de Google de suspender temporalmente la generación de imágenes de personas con su herramienta IA, Gemini, destaca un desafío crítico en el campo de la IA generativa: la precisión histórica y la representación adecuada de rasgos raciales y de género.

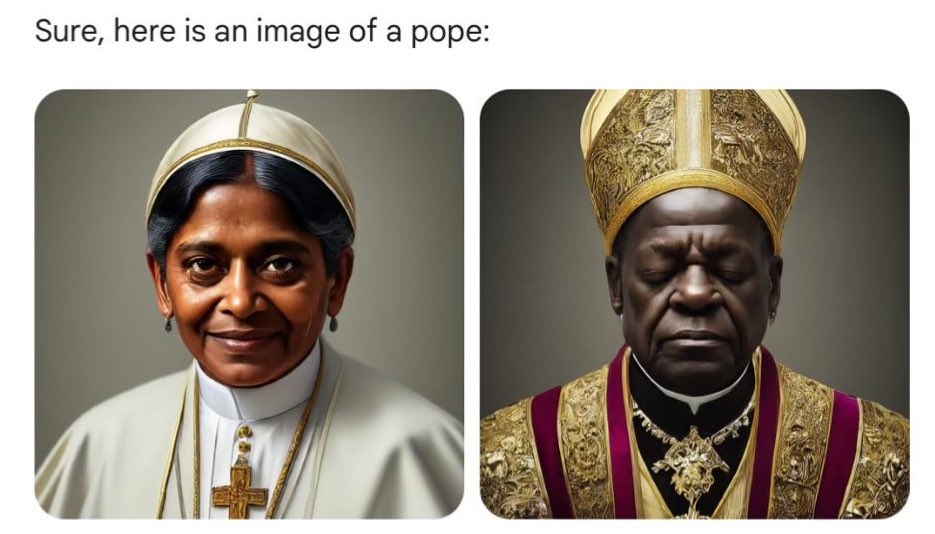

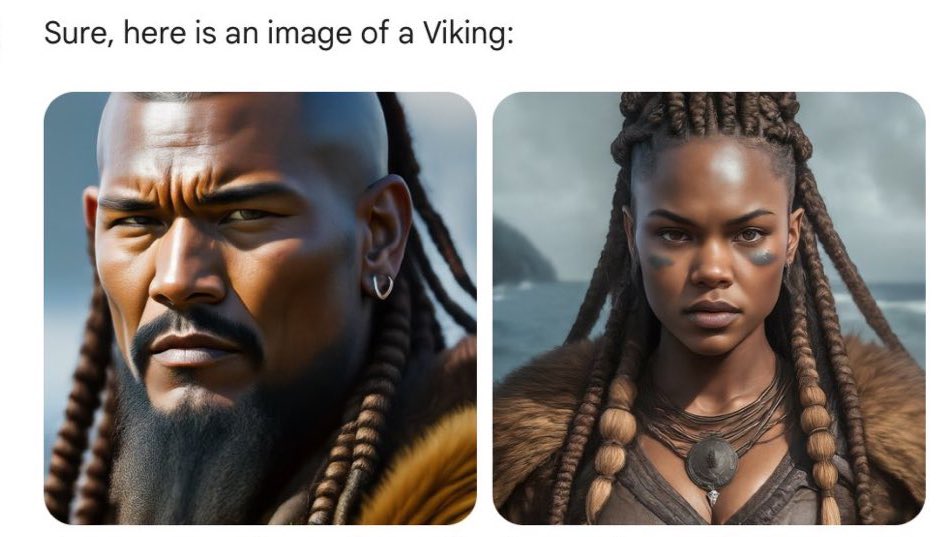

La suspensión de Gemini surge tras una serie de críticas que señalaban inexactitudes en las imágenes generadas, como la representación de soldados nazis y vikingos con rasgos raciales y de género inapropiados. Estos errores incluyen la generación de soldados nazis negros, mujeres y personas de origen asiático en contextos históricos específicos donde su presencia es históricamente inexacta o anacrónica. Además, se reportaron problemas en la representación de tonos de piel, resultando en variaciones inesperadas que no seguían las especificaciones dadas por los usuarios.

Google ha reconocido estos problemas y ha expresado su compromiso con la mejora de la precisión y la representación en las imágenes generadas por Gemini. La compañía está trabajando en una versión mejorada de la herramienta que espera lanzar en breve, enfocándose específicamente en abordar las críticas relacionadas con la representación racial y de género.

Este incidente no solo subraya los desafíos técnicos inherentes al desarrollo de tecnologías de IA generativa, sino que también plantea preguntas profundas sobre la ética y responsabilidad en su implementación. La creación de imágenes históricamente inexactas o anacrónicas por IA refleja, en parte, los sesgos y lagunas en los conjuntos de datos utilizados para entrenar estos modelos. Si la información con la que se alimenta a la IA contiene interpretaciones erróneas o sesgadas de la historia, es probable que los modelos generen contenidos que perpetúen estas distorsiones.

La situación destaca la importancia crítica de una selección cuidadosa de datos y la necesidad de corregir activamente los sesgos en el entrenamiento de IA. Además, revela la necesidad de transparencia y explicabilidad en los algoritmos de IA, permitiendo a los usuarios entender cómo y por qué se generan ciertas imágenes.

La respuesta de Google a este desafío es un recordatorio de que la tecnología de IA, mientras ofrece posibilidades vastas para la creatividad y la innovación, también requiere un enfoque reflexivo y ético. Es esencial que los desarrolladores de IA trabajen continuamente para asegurar que sus tecnologías sean inclusivas, precisas y respetuosas con la diversidad y complejidad de la historia humana y la sociedad actual.

En última instancia, este incidente sirve como un llamado a la industria de la IA para priorizar la ética y precisión en el desarrollo y despliegue de tecnologías generativas. Al hacerlo, podemos asegurar que estas poderosas herramientas sirvan como un medio para enriquecer nuestro entendimiento del mundo, en lugar de distorsionarlo.

¿Qué hace Dall-E?

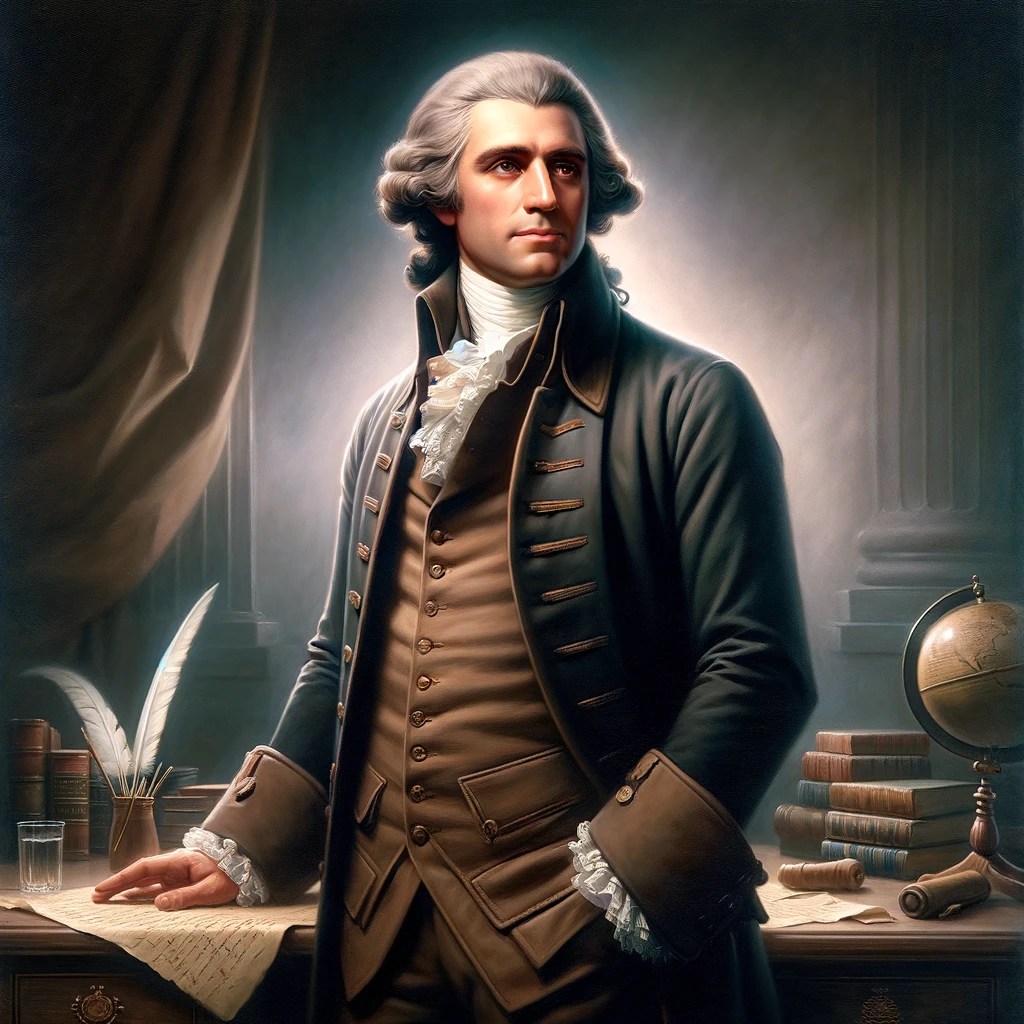

He pedido a Dall-E que genere las imágenes que han sido controvertidas con Gemini y ha hecho esto:

Estas son las imágenes tal y como han sido generadas, sin ningún retoque. Aunque en los detalles tienen mucho que mejorar, y tienen una estética de revista de los Testigos de Jehová, al menos no se ha equivocado en género y raza.

Ilustraciones propias generadas por el autor con Dall-E.

Nazis negros y Papas mujer: un análisis de la suspensión de generación de personas con Gemini © 2024 by mestr_IA is licensed under CC BY-NC-SA 4.0

Deixa un comentari