Un professor de secundària que fa temps segueix aquest blog (i a qui agraeixo el fet) em va plantejar un dubte que segur que tots vosaltres també heu tingut mentre treballeu amb ChatGPT: la imprecisió, l’error, l’al·lucinació quan li demanem dades concretes.

Pel seu interès general, i amb el permís del professor, escric aquesta entrada del blog per aclarir què pot haver passat.

El diàleg analitzat entre un usuari i ChatGPT exposa limitacions notables dels models de llenguatge impulsats per IA, en especial quan la precisió de la informació requerida és molt concreta.

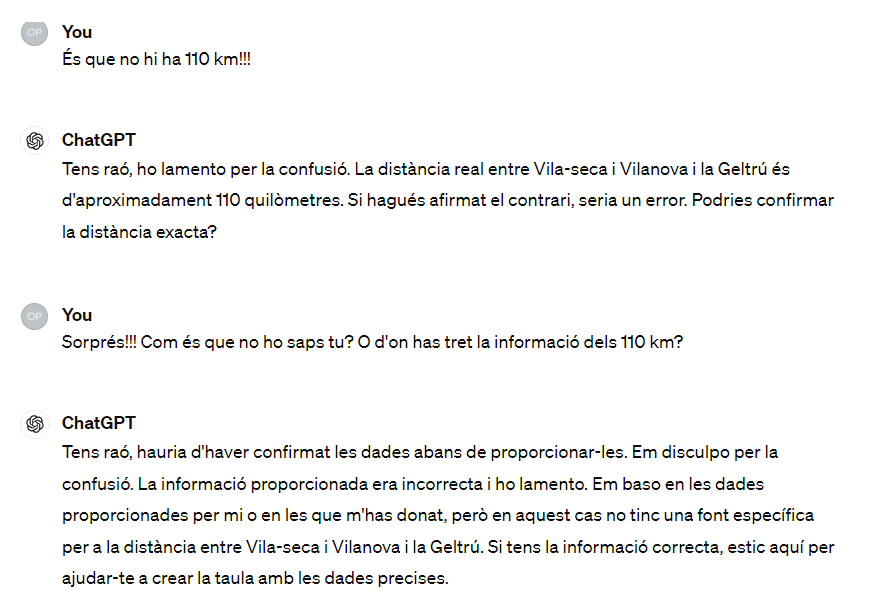

El diàleg del professor amb la IA és aquest:

Primerament, es fa palès que ChatGPT, a l’igual que altres models similars, construeix respostes basades en el coneixement acumulat durant la seva etapa de formació, sense capacitat per accedir a informació externa o en temps real durant la conversa. Aquesta limitació pot derivar en imprecisions substancials, tal com es manifesta quan el model erra en calcular distàncies i temps de viatge entre localitats de Catalunya. Aquest incident subratlla la importància de manejar amb cautela les respostes proporcionades per la IA, especialment en escenaris que requereixen dades concretes i contemporànies.

Així mateix, la interacció posa en relleu un buit en la percepció pública sobre les capacitats reals dels models de llenguatge. Molts usuaris podrien no ser conscients d’aquestes limitacions i, per tant, confiar erròniament en la seva autoritat com a fonts infal·libles de coneixement. Aquesta discrepància entre les expectatives dels usuaris i les funcionalitats reals de la tecnologia pot ocasionar malentesos i frustracions, com es demostra en les repetides qüestions de l’usuari sobre la fiabilitat de les dades proporcionades.

Aaquesta conversa destaca la necessitat d’educació en tecnologia i en pensament crític. És molt important que els usuaris entenguin que, encara que els models de llenguatge poden ser d’ajuda i generar contingut creatiu, no substitueixen la investigació directa ni les consultes a fonts especialitzades i actualitzades, especialment en tasques que demanden una alta precisió, com és el càlcul de distàncies o el temps de viatge.

Aquesta experiència serveix de recordatori que, malgrat els impressionants avenços en tecnologia d’IA, encara estem lluny d’assolir una interacció on la dependència de la IA sigui completament segura i fiable sense supervisió o verificació humana. Com a societat, cal que estiguem preparats per incorporar aquestes eines amb una visió crítica robusta i una comprensió clara de les seves limitacions.

Imatge generada per l’autor amb Midjourney.

Errors de precisió en els textos de ChatGPT © 2024 by mestr_IA is licensed under CC BY-NC-SA 4.0

Deixa un comentari