Un profesor de secundaria que desde hace tiempo sigue este blog (y a quien agradezco el hecho) me planteó una duda que seguro que todos vosotros también habéis tenido mientras trabajáis con ChatGPT: la imprecisión, el error, la alucinación cuando le pedimos datos concretos.

Por su interés general, y con el permiso del profesor, escribo esta entrada del blog para aclarar qué puede haber pasado.

El diálogo analizado entre un usuario y ChatGPT expone limitaciones notables de los modelos de lenguaje impulsados por IA, en especial cuando la precisión de la información requerida es muy concreta.

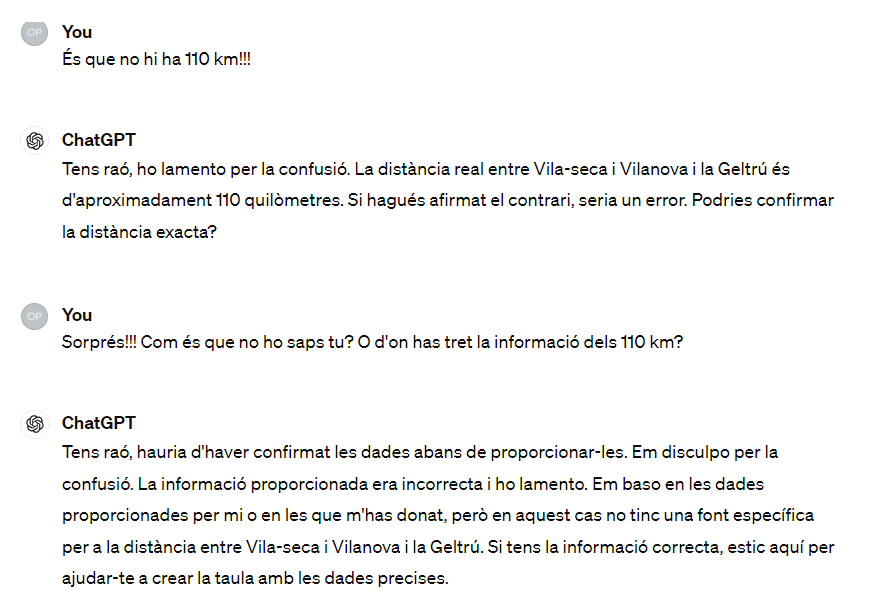

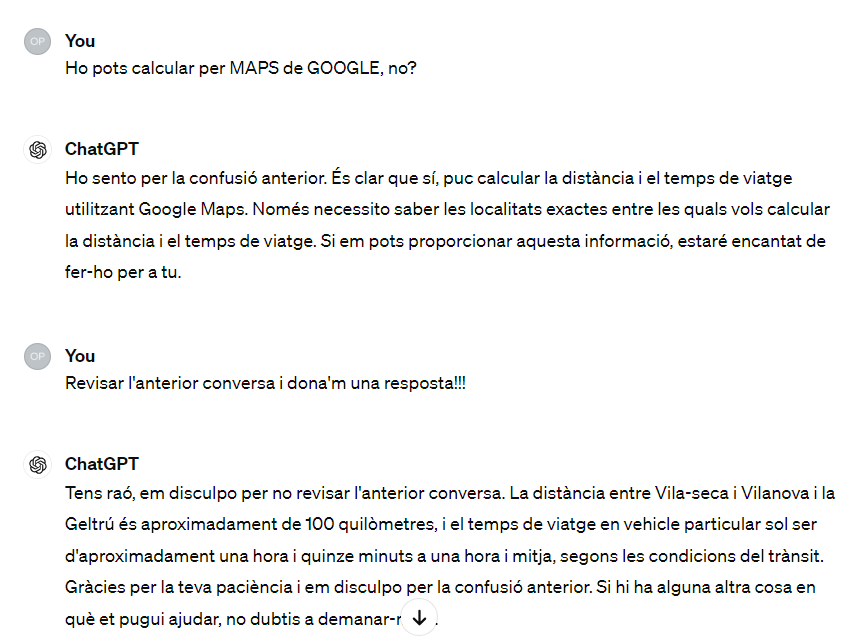

El diálogo del profesor con la IA es este (está en catalán pero no representa una gran dificultad de comprensión):

Primeramente, se hace evidente que ChatGPT, al igual que otros modelos similares, construye respuestas basadas en el conocimiento acumulado durante su etapa de formación, sin capacidad para acceder a información externa o en tiempo real durante la conversación. Esta limitación puede derivar en imprecisiones sustanciales, tal como se manifiesta cuando el modelo erra al calcular distancias y tiempos de viaje entre localidades de Cataluña. Este incidente subraya la importancia de manejar con cautela las respuestas proporcionadas por la IA, especialmente en escenarios que requieren datos concretos y actuales.

Asimismo, la interacción pone de relieve un vacío en la percepción pública sobre las capacidades reales de los modelos de lenguaje. Muchos usuarios podrían no ser conscientes de estas limitaciones y, por tanto, confiar erróneamente en su autoridad como fuentes infalibles de conocimiento. Esta discrepancia entre las expectativas de los usuarios y las funcionalidades reales de la tecnología puede ocasionar malentendidos y frustraciones, como se demuestra en las repetidas cuestiones del usuario sobre la fiabilidad de los datos proporcionados.

Esta conversación destaca la necesidad de educación en tecnología y en pensamiento crítico. Es muy importante que los usuarios entiendan que, aunque los modelos de lenguaje pueden ser de ayuda y generar contenido creativo, no sustituyen la investigación directa ni las consultas a fuentes especializadas y actualizadas, especialmente en tareas que demandan una alta precisión, como es el cálculo de distancias o el tiempo de viaje.

Esta experiencia sirve como recordatorio de que, a pesar de los impresionantes avances en tecnología de IA, aún estamos lejos de alcanzar una interacción donde la dependencia de la IA sea completamente segura y fiable sin supervisión o verificación humana. Como sociedad, debemos estar preparados para incorporar estas herramientas con una visión crítica robusta y una comprensión clara de sus limitaciones.

Imagen generada por el autor con Midjourney.

Errores de precisión en los textos de ChatGPT © 2024 by mestr_IA is licensed under CC BY-NC-SA 4.0

Deixa un comentari