La recent decisió de Google de suspendre temporalment la generació d’imatges de persones amb la seva nova eina IA, Gemini, destaca un repte crític en el camp de la IA generativa: la precisió històrica i la representació adequada de trets racials i de gènere.

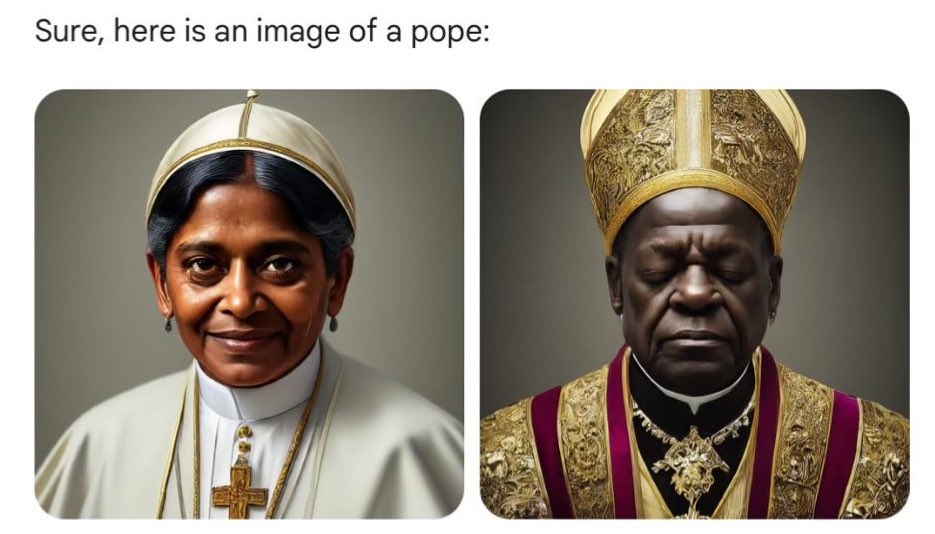

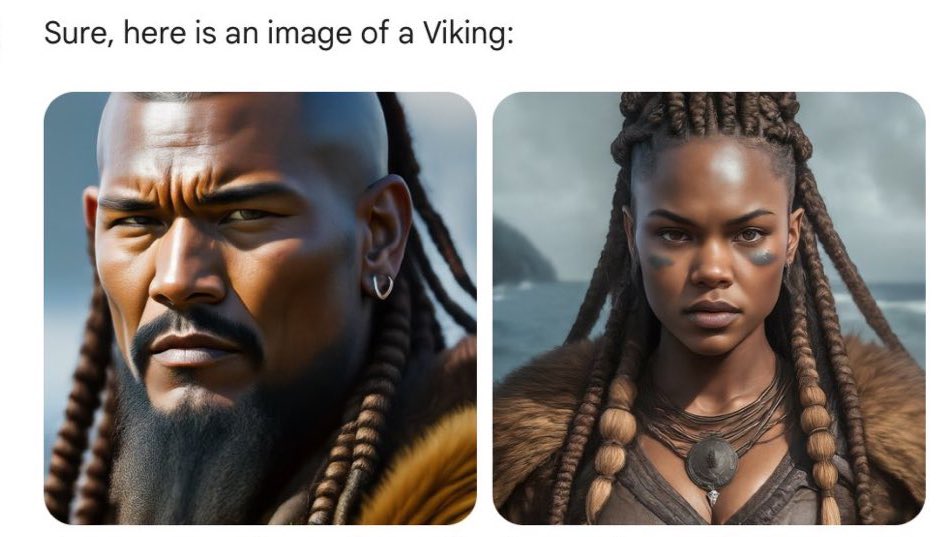

La suspensió de Gemini sorgeix després d’una sèrie de crítiques que assenyalaven inexactituds en les imatges generades, com la representació de soldats nazis i víkings amb trets racials i de gènere inadequats. Aquests errors inclouen la generació de soldats nazis negres, dones i persones d’origen asiàtic en contextos històrics específics on la seva presència és històricament inexacta o anacrònica. A més, es van reportar problemes en la representació de tons de pell, resultant en variacions inesperades que no seguien les especificacions donades pels usuaris.

Google ha reconegut aquests problemes i ha expressat el seu compromís amb la millora de la precisió i la representació en les imatges generades per Gemini. La companyia està treballant en una versió millorada de l’eina que espera llançar aviat, enfocant-se específicament en abordar les crítiques relacionades amb la representació racial i de gènere.

Aquest incident no només subratlla els desafiaments tècnics inherents al desenvolupament de tecnologies de IA generativa, sinó que també planteja preguntes profundes sobre l’ètica i responsabilitat en la seva implementació. La creació d’imatges històricament inexactes o anacròniques per IA reflecteix, en part, els biaixos i mancances en els conjunts de dades utilitzats per entrenar aquests models. Si la informació amb la qual s’alimenta a la IA conté interpretacions errònies o esbiaixades de la història, és probable que els models generin continguts que perpetuïn aquestes distorsions.

La situació destaca la importància crítica d’una selecció acurada de dades i la necessitat de corregir activament els biaixos en l’entrenament de IA. A més, revela la necessitat de transparència i explicabilitat en els algoritmes de IA, permetent als usuaris entendre com i per què es generen certes imatges.

La resposta de Google a aquest desafiament és un recordatori que la tecnologia de IA, mentre ofereix possibilitats vastes per a la creativitat i la innovació, també requereix un enfocament reflexiu i ètic. És essencial que els desenvolupadors de IA treballin contínuament per assegurar que les seves tecnologies siguin inclusives, precises i respectuoses amb la diversitat i complexitat de la història humana i la societat actual.

En última instància, aquest incident serveix com una crida a la indústria de la IA per prioritzar l’ètica i precisió en el desenvolupament i desplegament de tecnologies generatives. Fent-ho, ens assegurarem que aquestes poderoses eines serveixin com un mitjà per enriquir el nostre enteniment del món, en lloc de distorsionar-lo.

Què fa Dall-E?

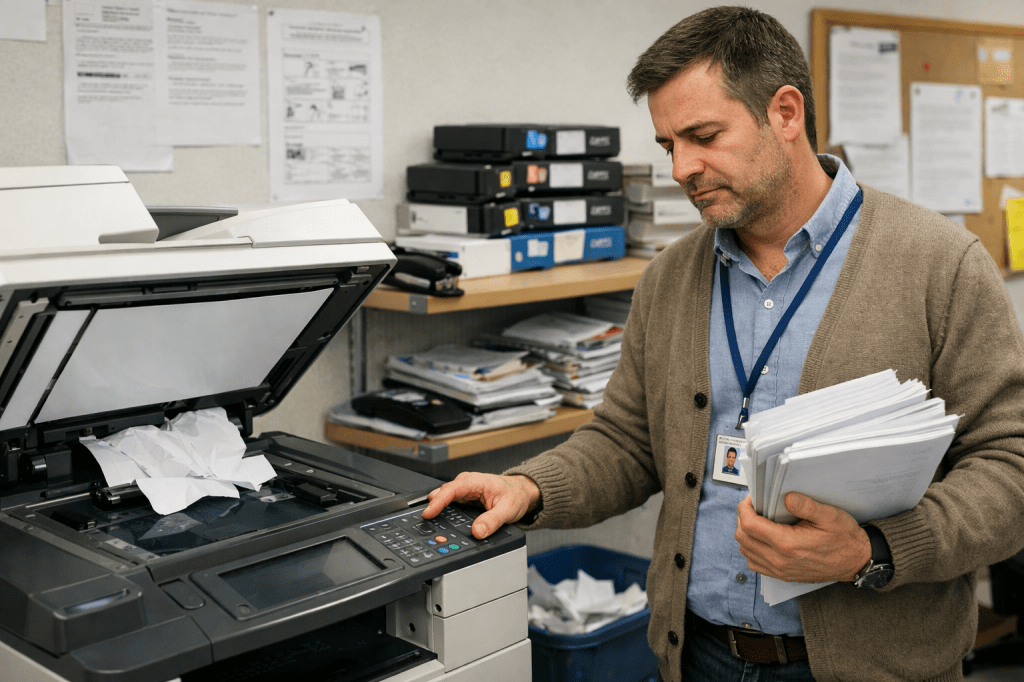

He demanat a Dall-E que generi les imatges que han estat controvertides amb Gemini i ha fet això:

Aquestes són les imatges tal i com han estat generades, sense cap retoc. Tot i que en els detalls tenen molt que millorar, i tenen una estètica de revista dels testimonis de Jehovà, al manco no s’ha equivocat en gènere i raça.

Il·lustracions pròpies generades per l’autor amb Dall-E.

Nazis negres i Papes dona: una anàlisi de la suspensió de generació de persones amb Gemini © 2024 by mestr_IA is licensed under CC BY-NC-SA 4.0

Deixa una resposta a Nazis negros y Papas mujer: un análisis de la suspensión de generación de personas con Gemini – mestr_IΛ Cancel·la la resposta